Դիփֆեյքեր. ո՞վ և ինչու՞ է ստեղծում արհեստական պատկերներ և տեսագրություններ

Ինչպե՞ս կարելի է խաբել մարդկությանը արհեստական բանականությամբ , և ինչով է դա սպառնում մեզ:

Բարաք Օբաման վերջին խոսքերով կշտամբում է Դոնալդ Թրամփին, իսկ ԱՄՆ կոնգրեսի ներկայացուցիչների պալատի խոսնակ Նենսի Փելոսին, կարծես թե հարբած է: Քաղաքական սկանդալ առաջացրած երկու դեպքերն էլ տեսձայնագրված են, սակայն տեսագրությունները կեղծ են: Այժմ յուրաքանչյուր այդպիսի կեղծիք քննարկումների ալիք է բարձրացնում, բայց 10-15 տարի անց պատկերները և տեսագրությունները, որոնք գեներացվել են արհեստական նեյրոցանցի միջոցով, կդառնան մեր առօրյա փորձի մի մասը: Արդյո՞ք կարող ենք պաշտպանել մեզ՝ սեփական պատկերները անբարեխիղճ օգտագործելուց: Արդյո՞ք կցանկանանք իմանալ շրջապատող դեմքերից ո՞րն է իրականը և որն արհեստական բանականությամբ ստեղծվածը: Ինչպե՞ս են ստեղծվում դիփֆեյքերը և ինչպիսի՞ ապագա է դրանց սպասում:

Ինչ են դիփֆեյքերը և ինչպես են դրանք ստեղծում

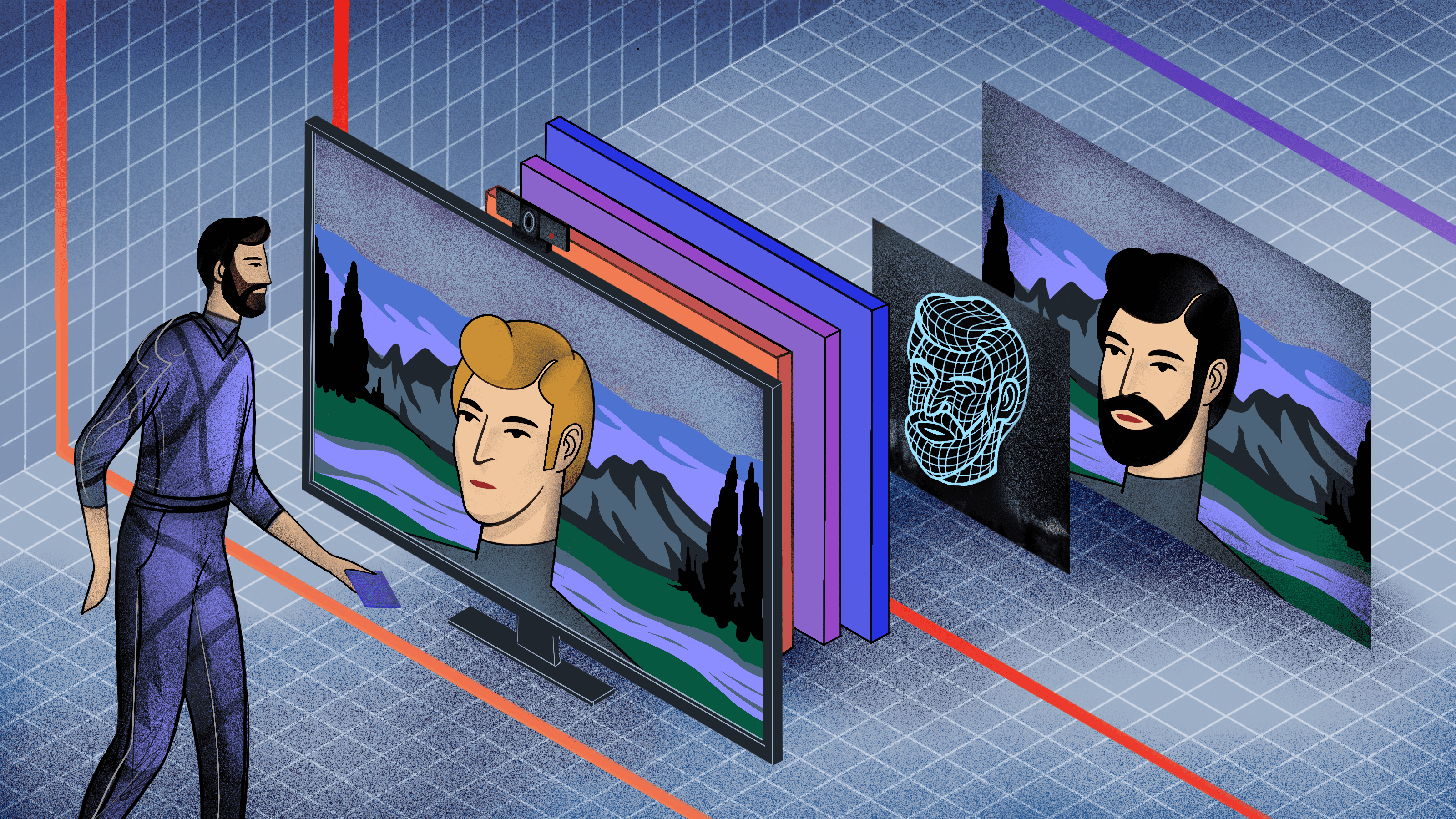

Դիփֆեյք են անվանում այն ֆոտոռեալիստական նկարները և տեսագրությունները, որոնք ստեղծվել են խորը նեյրոցանցերով: Այս եզրույթն օգտագործում են լրագրողները. հետազոտողներն այն կիրառում են առավել հազվադեպ:

Նեյրոցանցերն արդեն ունակ են գեներացնել իրական մարդկային դեմքեր և ձայներ: Դրա վառ օրինակն են Nvidia կազմակերպության GAN 2.0 և Deep Style GAN նախագծերը: Դրանց հիման վրա է ստեղծվել This Person Does Not Exist կայքը, որը էջը թարմացնելու դեպքում ամեն անգամ ստեղծում է նոր, գոյություն չունեցող դեմք: Այդ նկարները դժվարությամբ կարելի է տարբերել իրական մարդկանց նկարներից: Նույնը կարող ենք ասել Բարաք Օբամայի ելույթի մասին, որը գեներացվել էր նեյրոցանցի միջոցով և ներկայացվել էր 2017 թվականի SIGGRAPH համաժողովին. այնտեղ կեղծիքն անզեն աչքով հայտնաբերելը գործնականում անհնար է:

Մաթեմանտիկական գործողությունների տեսանկյունից նեյրոցանցերը, որոնք ստեղծում են անշարժ նկարներ և տեսագրություններ, միմյանցից չեն տարբերվում: Այնուամենայինիվ, դրանք տարբեր խնդիրներ են լուծում: Տեսագրություն ստեղծելիս անհրաժեշտ է ստեղծել պատկերի հաջորդականություն, մարդու շարժվող ձեռքը չպետք է կտրուկ կերպով դողդոջի կադրից կադր անցման ժամանակ, իսկ լուսավորությունը փոխվի (բացի այն դեպքերից, երբ այդպիսին է ռեժիսորի մտահաղացումը): Անցումների կապը ապահովում են ալգորիթմի միոդիֆիկացիաները, որոնք նոր կադր ձևավորելու ժամանակ հաշվի են առնում այն, ինչ կար նախորդում:

Որպեսզի տեսագրությունում մարդը լինի եռաչափ, անհրաժեշտ է ներյոցանց ներբեռնել օբյեկտի տարբեր ռակուրսներից արված նկարներ: Նկարները պետք է լինեն առավելագույնս որակյալ և քիչ թե շատ միանման. արդյունքը խղճալի կլինի, եթե վերցնենք նույն մարդու նկարը մորուքով և առանց մորուքի: Այդ պատճառով էլ չարժե վախենալ, որ չարամիտները ձեր պատկերի հիման վրա կստեղծեն դիփֆեյք՝ վերցնելով ձեր նկարը սոցցանցերից: Լուսանկարի հիման վրա որակյալ արհեստական պատկեր ստեղծելու համար պետք է մի քանի անգամ լուսանկարել տարբեր ռակուրսներից, ձեռքով ստեղծել 3D-մոդել, համադրել այդ 3D-մոդելի բազմաթիվ առանձին պատկերները և ներբեռնել այն նեյրոցանց:

Երբ են անհրաժեշտ դիփֆեյքերը

Ժամանակակից չատբոտեր և մարդակերպ ռոբոտներ արտադրողները միտումնաբար խուսափում են ռոբոտին ամբողջապես մարդուն նմանեցնելուց:

Նախ և առաջ, ռոբոտին՝ սառնարան նորոգել կարողանալու համար մարդկային դեմք պետք չէ: Ճապոնացի ռոբոտատեխնիկ Հիրոսի Իսիգուրոն, ով ստեղծում է մարդկանց իդեալապես նման ռոբոտներ, նշում է, որ նա դա անում է միայն ժամանակակից տեխնոլոգիաների հնարավորությունները ցույց տալու համար: Այդ նմանությունը օգտակար չէ:

Երկրորդ, պատկերների գեներացիայի համակարգերը դեռ իդեալական չեն. նմանակումները միշտ էլ վաղ թե ուշ իրենք իրենց մատնում են: Դիփֆեյքերը օժտված են մարդկայինից տարբերվող միմիկայով և շարժվում են ոչ այնպես, ինչպես դա անում է իրական մարդը, օրինակ՝ չափազանց հաճախ են թարթում աչքերը կամ շարժում գլուխը: Սարսափելի է թվում բոլոր նրանց համար, ովքեր դա նկատում են: Այս հոգեբանական երևույթը կոչվում է uncanny valley («չարագույժ հովիտ»): Որպեսզի օգտվողները այդ ամենին չբախվեն, արտադրողները թողնում են մարդու արտաքինի ամբողջական նմանակման փորձերը:

Այնուամենայինիվ կան բնագավառներ, որտեղ տեսողական միանմանությունն անհրաժեշտ է՝ կինեմատոգրաֆը, հատուկ էֆեկտները, հեռահաղորդակցության համար նախատեսված հավելվածները և նեյրոավատարները: Նունիսկ հայտնի FaceTime հավելվածը, որը նախատեսված է տեսազանգի համար, աշխատում է այդ ուղղությամբ: Այսպիսի տեխնոլոգիաներին մեծ ապագա է սպասվում նաև վիդեոխաղերի բնագավառում:

Արհեստական ինտելեկտի համակարգերը թույլ են տալիս ստեղծել թվային կլոն այն տվյալների հիման վրա, որոնք մնացել են մարդու մահից հետո: Գոյություն ունեն ընկերություններ, որոնք օգտագործում են մահացածների խոսակցություններն ու տեքստերը՝ վերջիններիս նման խոսող չատբոտեր գեներացնելու համար, իսկ կենդանության օրոք արված տեսագրությունները և նկարները թույլ են տալիս ստեղծել իրենց թվային ավատարները:

Այս հնարավորությունները առաջացնում են բազմաթիվ բարոյագիտական դիլեմաներ: Արդյո՞ք մենք իրավունք ունենք օգտագործել մահացած մարդու արտաքինն այնպես, որ նրա կերպարը կարողանա կատարել այնպիսի գործառույթներ, որոնց համար անհրաժեշտ կլիներ կենսաբանական մարմին կամ գործառույթ, օրինակ՝ շփվել: Հնարավո՞ր է այդ կերպ հասցնել ֆիլմի նկարահանումն ավարտին, եթե դերասանը մինչ այդ մահացել է: Կամ օգտագործել մահացած հայտնի մարդու 3D-ավատարը՝ լրիվ նոր ֆիլմ ստեղծելու համար, իսկ հետո օգտագործել իր կերպարը նաև գովազդում: Իրավական տեսանկյունից մարդու կերպարը տնօրինելու իրավունքը հետմահու անցնում է բարեկամներին. մահացածի արտաքին կերպարն օգտագործելը թույլ տալու կամ չտալու իրավունքը հենց նրանց է պատկանում: Բայց արդյո՞ք այդ ամենը ինչ-որ կերպ չի ոտնահարում անձի հիմնարար իրավունքները: Այս և շատ այլ հարցեր դեռ բաց են մնում:

Նեյրոավատարները օբյեկտների եռաչափ թվային մոդելներ են, որոնք ստեղծվում են նեյրոցանցերի օգնությամբ մի պատկերի հիման վրա:

Երբ են դիփֆեյքերը վտանգավոր

Տեխնոլոգիան չի կարող ինքնուրույն որոշել, թե ինչն է լավ և ինչը՝ վատ: Տեխնոլոգիայի գործողությունները ուղղակիորեն կախված են նրանից, թե ինչպիսի նպատակների հասնելու համար է այն ծրագրավորվել: Օրինակ՝ IBM Project Debater արհեստական ինտելեկտը մասնակցում է բանավեճերի: Հմտության մակարդակով այն չի զիջում բանավեճերի ոլորտում համաշխարհային չեմպիոններին. ծրագիրն ունակ է շատերին համոզել: Սա չի կարող չվախեցնել. չէ որ համակարգչիը թիրախավորում է մեկ այլ մարդու:

Դիփֆեյքերի հետ կապված հիմնական վախը տեսագրույթան մեջ մի մարդու պատկերը մեկ ուրիշով փոխարինելու հնարավորությունն է: Գրեթե ամբողջությամբ իրականությանը համապատասխանող կեղծ նկարները և տեսագրությունները կարող են օգտագործվել ապատեղեկատվության, խաբեբայության, պրովոկացիայի և համացանցային հալածանքների (кибербуллинг) համար: Չարագործները կարող են տեսագրության մեջ մարդու դեմքը փոխարինել և մեղադրել նրան իրավախախտման մեջ, շորթագործությամբ սպառնալ անհայտ կորածի հարազատներին գեներացված նկարներով կամ տեսագրություններով, ընտրողների որոշումների վրա ազդել՝ համացանցում կեղծ տեսագրություններ տարածելով:

2019 թվականին դիփֆեյքերն առաջին անգամ աշխարհաքաղաքական ցնցում առաջացրին: Մայիսի վերջին Դոնալդ Թրամփը մի հոլովակ հրապարակեց ԱՄՆ կոնգրեսի խոսնակ Նենսի Փելոսիի հետ, որտեղ վերջինս հարբած էր երևում: Սկզբնական տեսագրության համեմատ հոլովակի արագությունը 25%-ով նվազեցված էր, իսկ ձայնը այնպես էր փոխված, որ թվա, թե նա խոսում է ընդհատումներով: Այս տեսագրության հայտնվելուց հետո ԱՄՆ կոնգրեսը հետաքննություն սկսեց և հայտարարեց, որ այսպիսի հոլովակները կարող են անուղղելի վնաս հասցնել 2020 թվականի ընտրություններին: Տեխնոլոգիայի զարգացման հետ իրավիճակը կարող է ավելի վատանալ:

Հնարավո՞ր է անզեն աչքով տարբերել կեղծ պատկերները իրականներից

Առաջին մի քանի վայրկյաններին մարդը չի կարող ասել, թե ինչպիսի նկար է իր դիմաց՝ գեներացվա՞ծ, թե՞ իսկական: Բայց եթե ուշադիր նայենք, գեներացված նկարը անզեն աչքով իրականից տարբերել դեռևս հնարավոր է:

Առաջին հերթին պետք է ուշադրություն դարձնել պատկերի չափերին: Մեծ ծավալի իրատեսական պատկերներ ստեղծելը ավելի բարդ է, քան փոքր ծավալի, այդ իսկ պատճառով մեծ պատկերներին դեռ կարելի է վստահել: Երկրորդ՝ ուշադիր նայեք դեմքերին, որպեսզի կարողանաք գտնել ոչ բնական անհամաչափություններ: Օրինակ՝ ձախ աչքի կտրվածքը կարող է չհամապատասխանել աջին: Երրորդ՝ հագուստ կամ զարդեր ստեղծելը նեյրոցանցերին ավելի դժվար է տրվում քան դեմքերի ստեղծումը: Չորրորդ՝ դիփֆեյքերին հաճախ մատնում է անիրական կամ շատ աբստրակտ և ոչ պարզ ֆոնը:

Դիփֆեյքային մոտեցումների առանձին դասը ներառում է նկարում պատկերված մարդու դեմքի փոխարինումը մեկ ուրիշով: Այս երևույթն անվանում են նաև faceswap: Եթե ուշադրություն դարձնենք, ապա կնկատենք կցվածություն կամ ողջ նկարի լուսավորությանը անհմապատասխան դեմքի լուսավորություն:

Իսկ տեսագրության մեջ պետք է հետևել, թե ինչպես է ժամանակի ընթացքում փոխվում մարդու դեմքը: Օրինակ՝ աչքերը տարօրինակ կերպով թարթելը դիփֆեյքի նշան է:

Բացի վերոհիշյալ միջոցներից՝ դիփֆեյքը կարելի է բացահայտվել նիշքի պատմության միջոցով: Դրա համար կարելի է օգտագործել վերիֆիկացիայի ստանդարտ մեթոդնեը, օրինակ՝ պատկերի ձայների վիճակագրությունը, ինչը թույլ է տալիս որոշել այն լուսանկարչական ապարատի մոդելը, որի միջոցով նկարահանվել է կադրը:

Ինչպես հայտնաբերել դիպֆեյքը նեյրոցանցի միջոցով

Բայց հիմա ցածրորակ կեղծ նկարները չեն տարբերվում իրականներից: Առաջընթացն արագ է.. 10-15 տարի անց և´ 4K ձևաչափով , և´ ավելի բարձր որակի, իրականությանը գրեթե ամբողջապես համապատասխանող տեսագրությունները մեզ չեն զարմացնի: Բացի այդ՝ գեներատիվ նեյրոցանցերի օգնությամբ մենք կարող ենք շրջել վիրտուալ իրականության մեջ՝ ֆոտոռեալիստական աշխարհով, որտեղ տարբեր իրադարձություններ են տեղի ունենում: Որքան արագ են զարգանում ֆեյքեր ստեղծող տեխնոլոգիաները, այնքան արագ էլ, և նույնիսկ ավելի արագ, պետք է զարգանան այն տեխնոլոգիաները, որոնք դրանք բացահայտում են:

Հասարակ օգտատերերի համար մասնագետները մշակում են տեսագրության պարզ անալիզատորներ, որոնք կողմնորոշվելու են թարթելու և ադամախնձորի շարժումների հաշվին: Բայց հիմա բացահայտող համակարգ ստեղծելու բոլոր փորձերը հանգեցնում են այն բանին, որ բազմաթիվ իրական տեսագրություններ դիտարկվում են որպես դիփֆեյքեր, որովհետև որոշ մարդիկ ունեն գծեր, որոնք բնորոշ են արհետականորեն ստեղծված պատկերներին: Դա կարող է լինել աչքերն անսովոր կերպով թարթելը, տարօրինակ ձև ունեցող մորուքը, անհամաչափ դիմագծերը: Թվում է, դա հետճշմարիտ աշխարհի լավագույն օրինակն է. այն տվյալները, որոնք մենք ունենք, դեռ թույլ չեն տալիս ստեղծել լավ անտիֆեյք ծրագիր, չնայած նրան, որ ֆեյքերը ավելի են շատանում:

Դիփֆեյքերի բացահայտումը առաջին հերթին նեյրոցանցերի առաքելությունն է: Որպեսզի դրանք դիփֆեյքերը բացահայտել կարողանան, անհրաժեշտ է նեյրոցանց բեռնել սովորեցնող հավաքածու, որտեղ կլինեն և´ իրական, և´ արհեստականորեն ստեղծված պատկերներ: Դա թույլ կտա նեյրոցանցերին սովորեցնել գտնելու այն բարդ նշանները, որոնք տարբերում են կեղծ պատկերենրը իրականներից: Մեր օրերում այս տիպի բոլոր ծրագրերը իրական նկարները կեղծ են համարում, և այս խնդիրը մասնագետները դեռ պետք է հաղթահարեն:

Որպեսզի նեյրոցանցերը սովորեն կեղծ պատկերները իրականներից տարբերել, անհրաժեշտ է բեռնել մեծ քանակությամբ տվյալներ: Միայն 2019 թվականին սկսվեց պահեստների՝ ֆեյքերը տարբերակելու որակի գնահատման համար նկարների հավաքածուների ստեղծումը: Նեյրոցանցերին վարժեցնելու գործընթացը արագ չէ, այդ պատճառով դրանք ֆեյքերը իրականից տարբերակել կսովորեն միայն երկու տարի անց:

Գոյություն ունի նաև վերավարժեցնելու խնդիրը: Բանն այն է, որ նեյրոցանցերը, որպես օրենք, սովորում են որակյալ պատկերների վրա, բայց հաճախ պետք է աշխատել ոչ այնքան որակյալ բովանդակության հետ: Այսպիսի դեպքերում մասնագետները գործի են դնում միանգամից մի քանի նեյրոցանցեր, որոնք միասին են մասնակցում պատկերը բացահայտելու գործում, իսկ հետո «միասնական որոշումներ» են կայացնում: Տեսականորոն փորձագետները կարող են նեյրոցանցերը վարժեցնել նաև անորակ պատկերների վրա, բայց ինչպես դա ճիշտ ձևով անել, պարզ կլինի միայն 5-10 տարի անց:

Հետաքրքիր է այն, որ ֆեյքերը բացահայտող յուրաքանչյուր նոր արդյունավետ որոշում կհանգեցնի դրանց բարելավմանը: Որոշ իմաստով ստացվում է խմբային մակարդակում գործող միջմրցողական ցանց:

Դիփֆեյքերը և օրենքը

Դիփֆեյքերից պաշտպանվելու համար դրանք բացահայտելը բավական չէ: Պետք է ստեղծել անվտանգ մեխանիզմներ տվյալները անհատական թվային գրության միջոցով փոխանցելու համար, որը թույլ կտա հաստատել կամ ժխտել այս կամ այն տեղեկության իրական լինեը: Բայց թվային գրության իսկությունը ևս չլուծված խնդիր է:

Սոցկայքերը արդեն իսկ սկսել են պայքարել դիփֆեյքերի տարածման դեմ: Որոշները ջնջում են նեյրոցանցերի միջոցով ստեղծված հոլովակները, մյուսները սահմանափակում են դրանց ծավալները: Մարդիկ, ում պատկերը օգտագործել են առանց իրազեկման, դիմում են հեղինակային իրավունքների պաշտպանության մասին օրենքին, բայց, ի պատասխան դրան, դիփֆեյքեր ստեղծողները նշում են խոսքի ազատության խախտման մասին:

Ապագայում մեզ կարող են սպասել հետաքրքիր իրավական կոլիզիաներ: Իրավապահները կպաշտպանեն օգտատերերի իրավունքները, բայց դրա հետ մեկտեղ տեխնոլոգիայի ազդեցության տակ կփոխվեն իրենց լիիրավության մասին պատկերացումները: Օրինակ՝ պետությունը կարող է որոշել, թե ինչ պետք է իմանա օգտատերը. իր առջև տեսնում է իրական առարկայի պատկե՞ր, թե՞ գեներացված կերպար: Իսկ օգտատերը կարող է բողոքարկել. չէ որ, օրինակ, վիդեոխաղում կարևոր չէ՝ ֆոնային բնապատկերները գեներացված են, թե՝ ոչ: Իրավունքը և ընդհանրապես նորմատիվ ոլորտը միշտ փոքր-ինչ չեն հասցնում տեխնիկական փոփոխությունների հետևից:

Թարգմանիչ՝ Սյուզաննա Ղազարյան (Syuzanna Ghazaryan) © Բոլոր իրավունքները պաշտպանված են: